发布日期:2024-05-22 11:00 点击次数:77

裁剪:alan

最自制的大模子基准测试降生了!来自LLM竞技场,最接近东谈主类偏好,数据崭新、速率快、本钱低,严格分离学渣和学霸。

大模子排名榜哪家强?还看LLM竞技场~

松手此刻,已有整个90名LLM加入宣战,用户总投票数越过了77万。

但是,在网友们吃瓜辱弄新模子冲榜、老模子丧失尊荣的同期,

东谈主家竞技场背后的组织LMSYS,一经暗暗完成了后果滚动:从实战中降生的最有劝服力的基准测试——Arena-Hard。

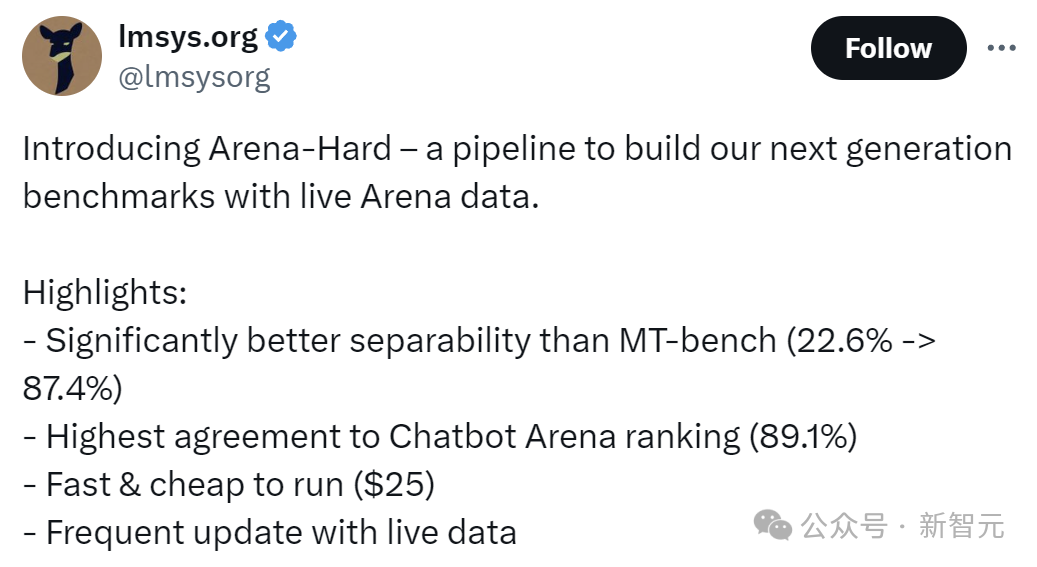

而Arena-Hard所展现出的四项上风,也恰是刻下的LLM基准测试最需要的:

-可分离性(87.4%)显然优于MT-bench(22.6%);

-与Chatbot Arena的排名最周边,达到89.1%;

-启动速率快,价钱低廉(25好意思元)

-频繁更新及时数据

中译中一下即是,最初这个大模子的检修要有永别度,不成让学渣也考到90分;

其次,检修的题目应该更贴合骨子,何况打分的期间要严格对皆东谈主类偏好;

终末一定不成泄题,是以测试数据要相同更新,保证检修的自制;

——后两项条目关于LLM竞技场来说,险些像是量身定作念。

咱们来看一下新基准测试的效果:

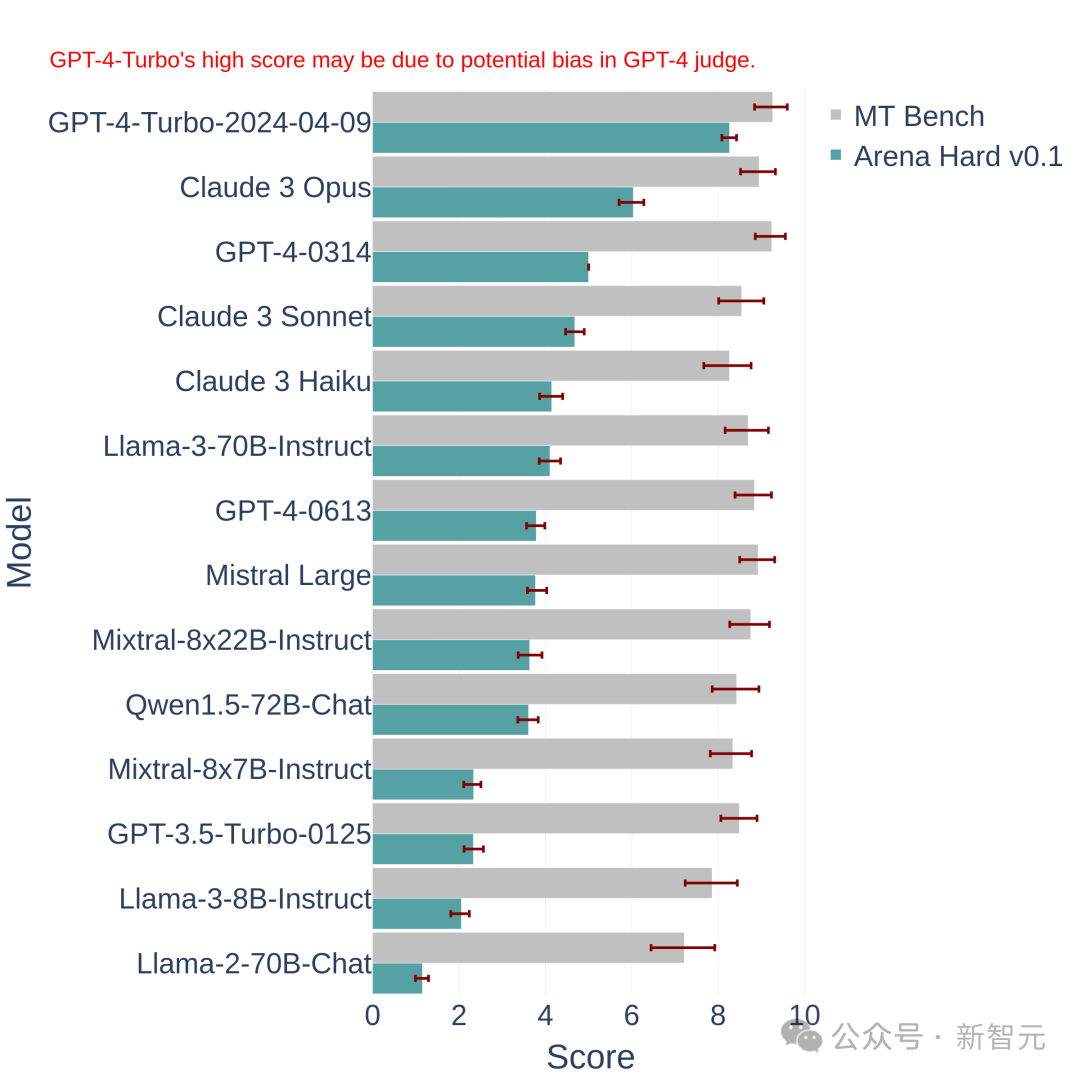

上图中将Arena Hard v0.1,与之前的SOTA基准测试MT Bench进行了比较。

咱们不错发现,Arena Hard v0.1与MT Bench比拟,具有更强的可分离性(从22.6%飙升到了87.4%),何况置信区间也更窄。

另外,看下这个排名,与底下最新的LLM竞技场排名榜是基本一致的:

这确认Arena Hard的评测高出接近东谈主类的偏好(89.1%)。

——Arena Hard也算是拓荒了众包的新玩法:

网友赢得了免费的体验,官方平台赢得了最有影响力的排名榜,以及崭新的、高质地的数据——莫得东谈主受伤的寰宇完成了。

给大模子出题

底下看下怎样构建这个基准测试。

简便来说,即是怎样从竞技场的20万个用户教唆(问题)中,挑出来一些比较好的。

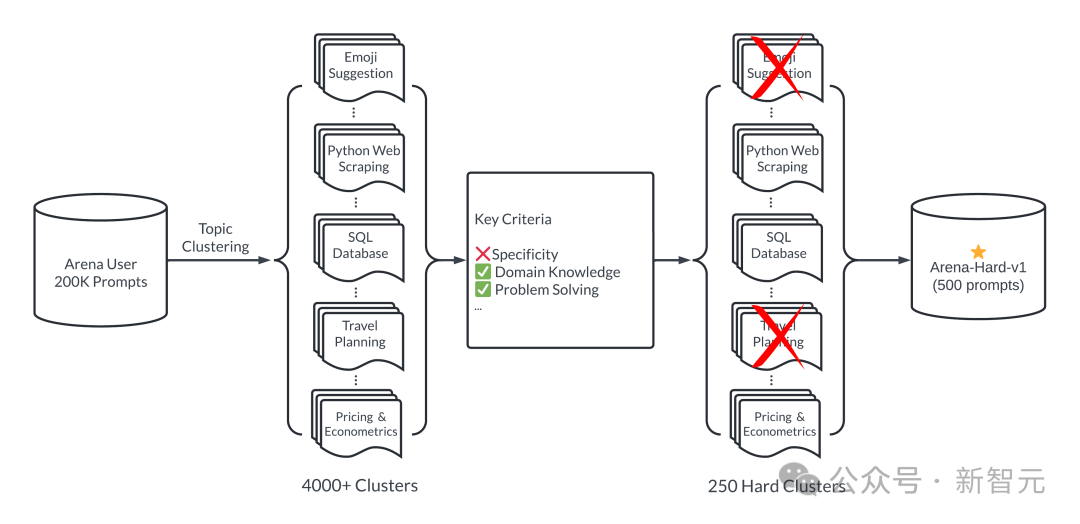

这个「好」体面前两方面:各样性和复杂性。下图展示了Arena-Hard的责任流:

归来一波:最初对通盘教唆进行分类(这里分了4000多个主题),然后东谈主为制定一些范例,对每个教唆进行打分,吞并类别的教唆算平平分。

得分高的类别不错以为复杂性(概况质地)高——也即是Arena-Hard中「Hard」的含义。

及第前250个得分最高的类别(250保证了各样性),每个类别立时抽2位运道教唆,构成最终的基准测试集(500 prompts)。

底下详备张开:

各样性

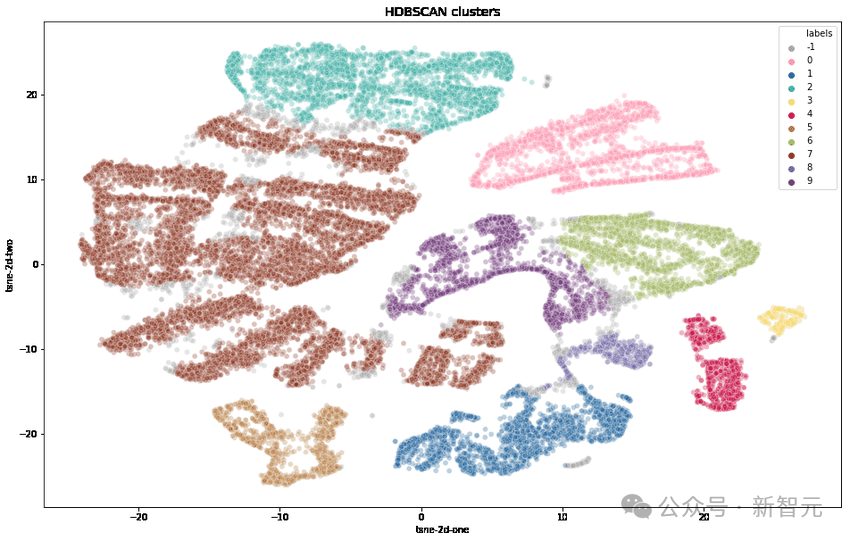

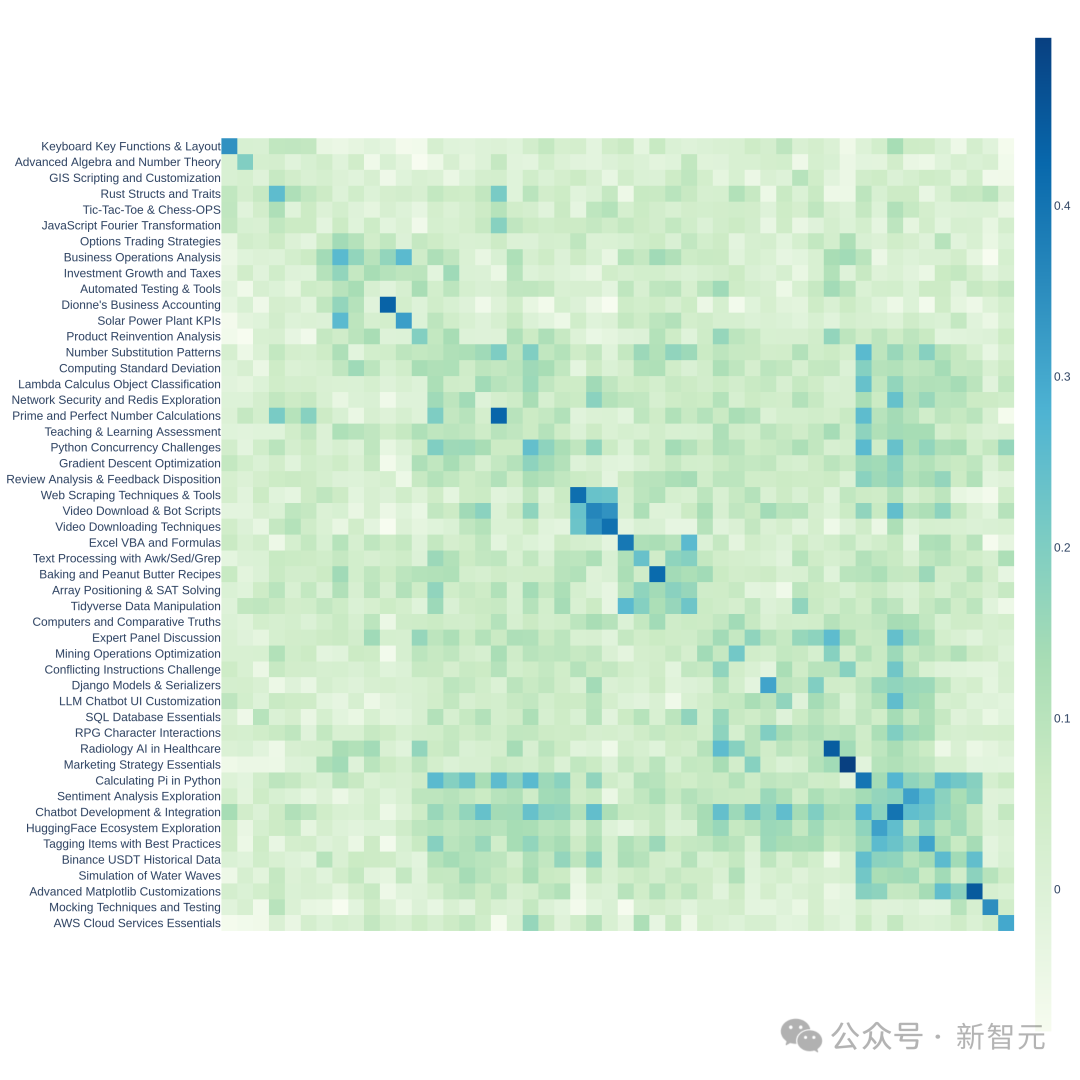

询查东谈主员最初使用OpenAI的text-embedding-3-small调理每个教唆,使用UMAP减少维度,并使用基于分层的聚类算法(HDBSCAN)来识别聚类,然后使用GPT-4-turbo进行汇总。

复杂性

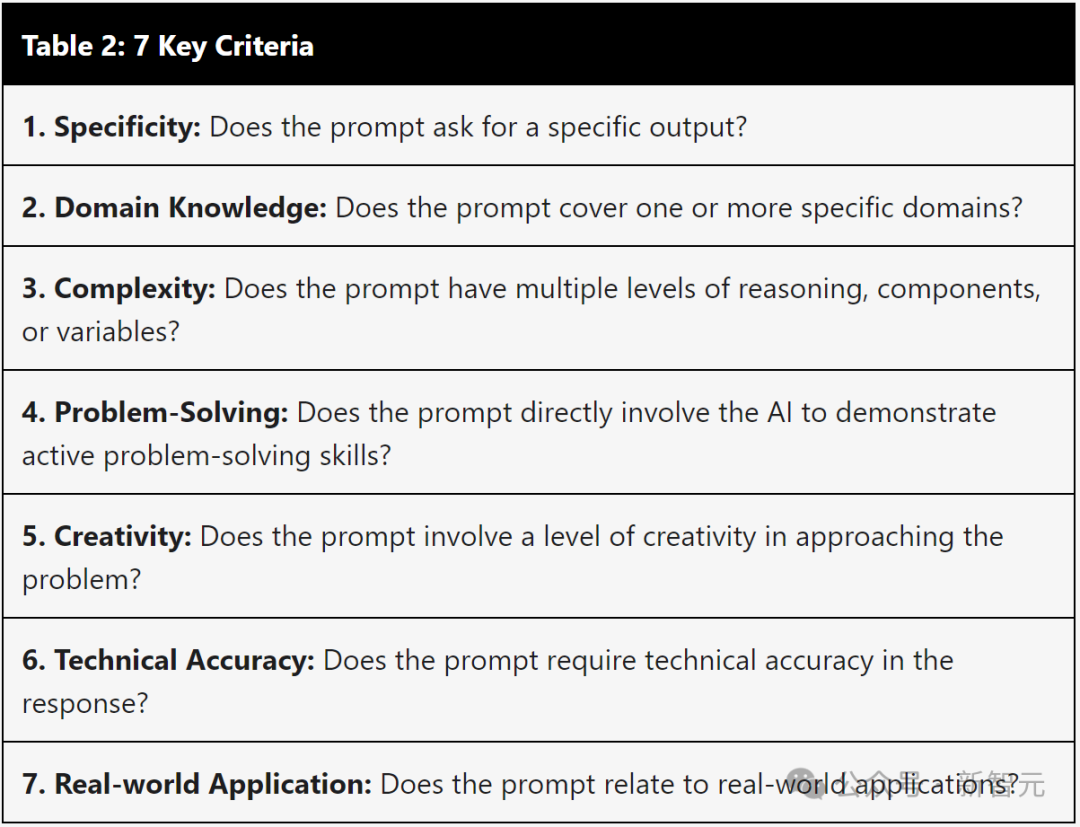

通过下表的七个要害范例来采选高质地的用户查询:

1.教唆是否条目提供特定的输出?

2.是否涵盖一个或多个特定范畴?

3.是否具有多个级别的推理、组件或变量?

4.是否成功让AI展示科罚问题的才智?

5.是否触及一定进程的创造力?

6.是否条目反馈的技艺准确性?

7.是否与骨子期骗研究?

关于每个教唆,使用LLM(GPT-3.5-Turbo、GPT-4-Turbo)标注其知足了几许个范例(打分0到7),然后,预料每组教唆(聚类)的平平分数。

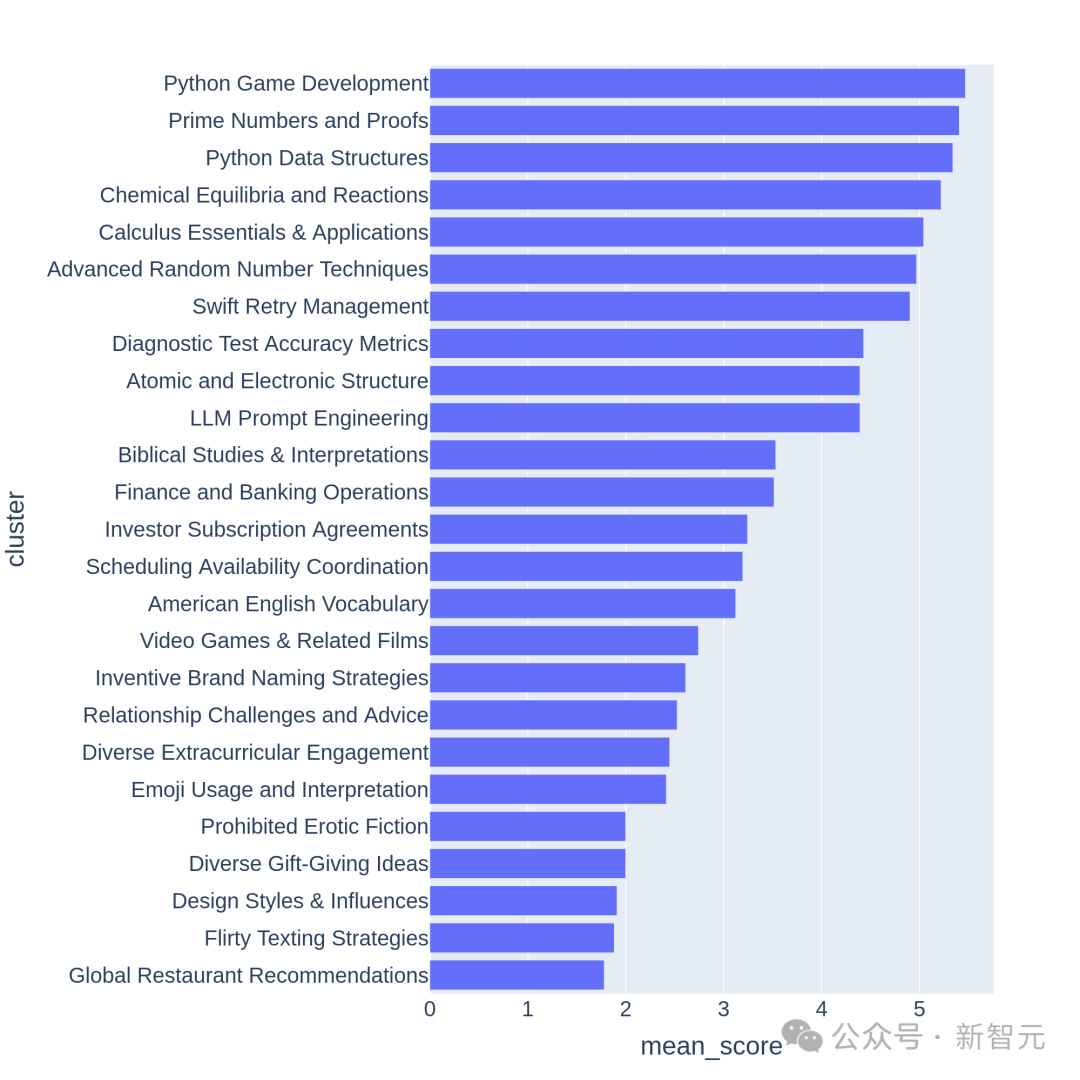

下图展示了部分聚类的平平分排序:

咱们不错不雅察到,得分较高的聚类庸俗是比较有挑战性的主题(比如游戏诞生、数学证明),而分数较低的聚类则属于琐碎或拖泥带水的问题。

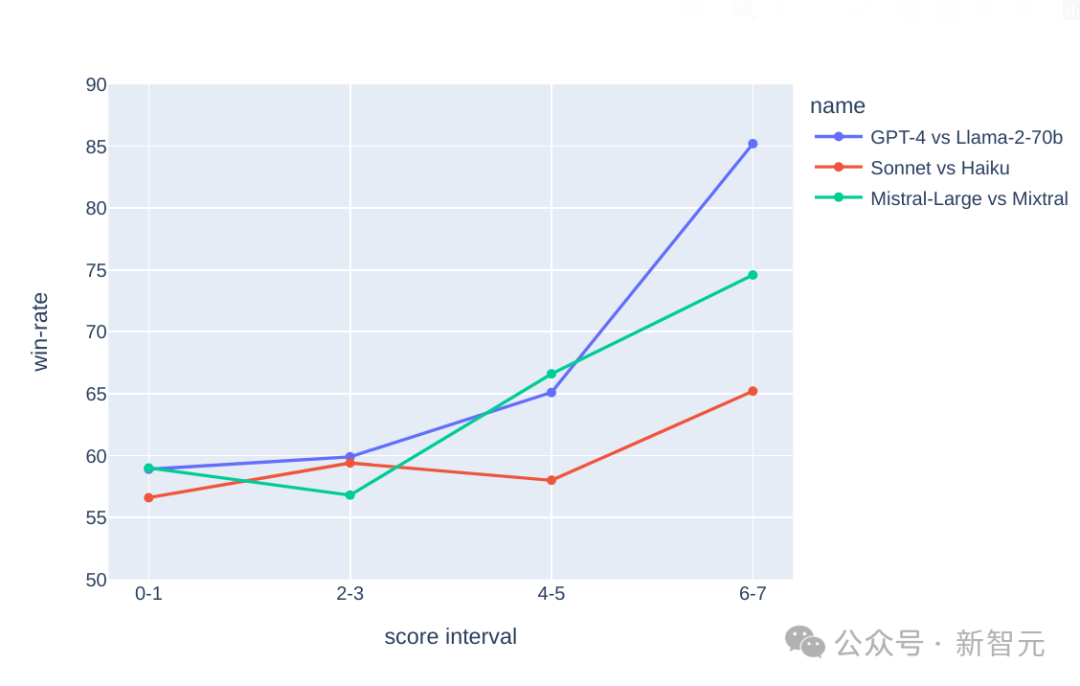

有了这个复杂性,就不错拉开学霸与学渣之间的差距,咱们看底下的履行弃世:

在上头的3个比较中,假定GPT-4比Llama2-70b强、Claude的大杯比中杯强,Mistral-Large比Mixtral强,

咱们不错看到,跟着(复杂性)分数的增多,更强的模子的胜率也在擢升——学霸赢得永别、学渣赢得过滤。

因为分数越好高(问题越复杂),永别度越好,是以最终及第了250 个平均得分>=6分(满分7分)的高质地分类。

然后,立时抽取每个类别的2个教唆,股票配资哪家好酿成了这版基准测试—— Arena-Hard-v0.1。

判卷老诚靠谱吗?

试卷出罢了,谁来判卷是个问题。

东谈主工天然是最准的,而且因为这是「Hard步地」,许多触及范畴学问的问题还需要行家前来评估——这显然不行。

那么退而求其次,采选面前公认的最聪惠的模子GPT-4来当判卷老诚。

比如上头的那些图表中,触及打分的挨次,都是交给GPT-4来作念的。另外,询查东谈主员使用CoT教唆LLM,在作念出判决之前先生成谜底。

GPT-4 判出的弃世

底下使用gpt-4-1106-preview行为判断模子,用于比较的基线罗致gpt-4-0314。

上表中比较并预料了每个模子的Bradley-Terry系数,并调理为联系于基线的胜率行为最终分数。95%置信区间是通过100轮指点预料得出的。

克劳德暗示不屈

——我Claude-3 Opus亦然排名榜比肩第一啊,凭啥让GPT当判卷老诚?

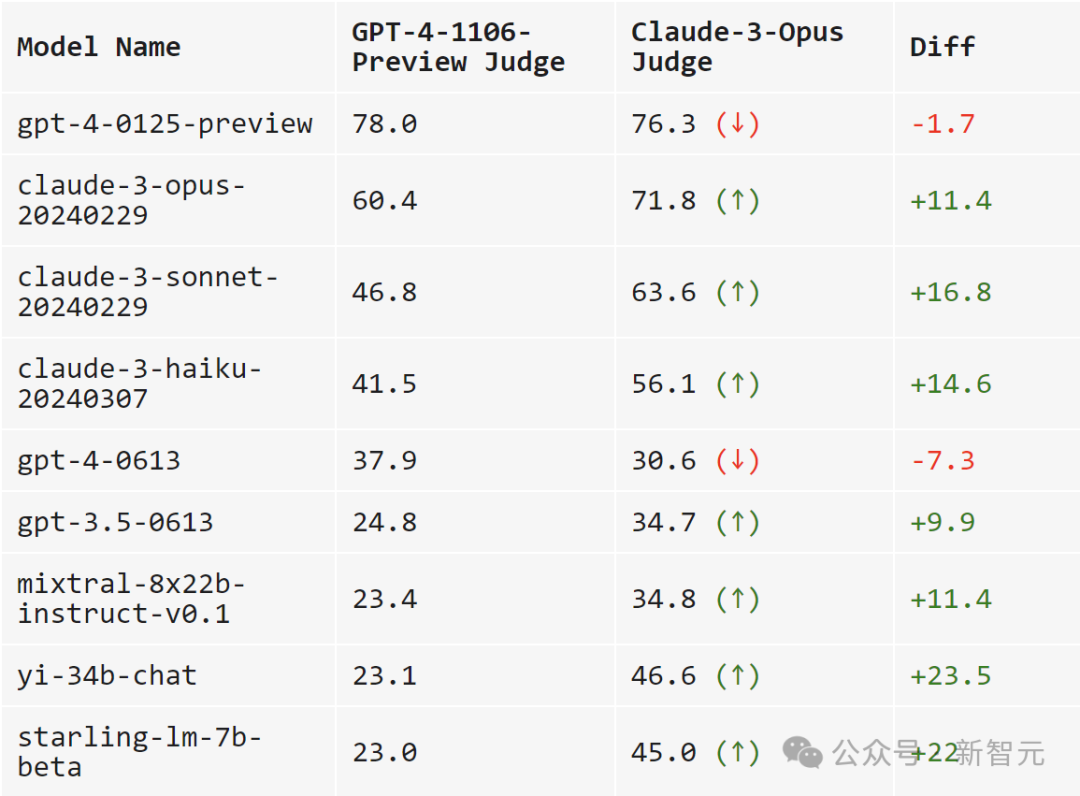

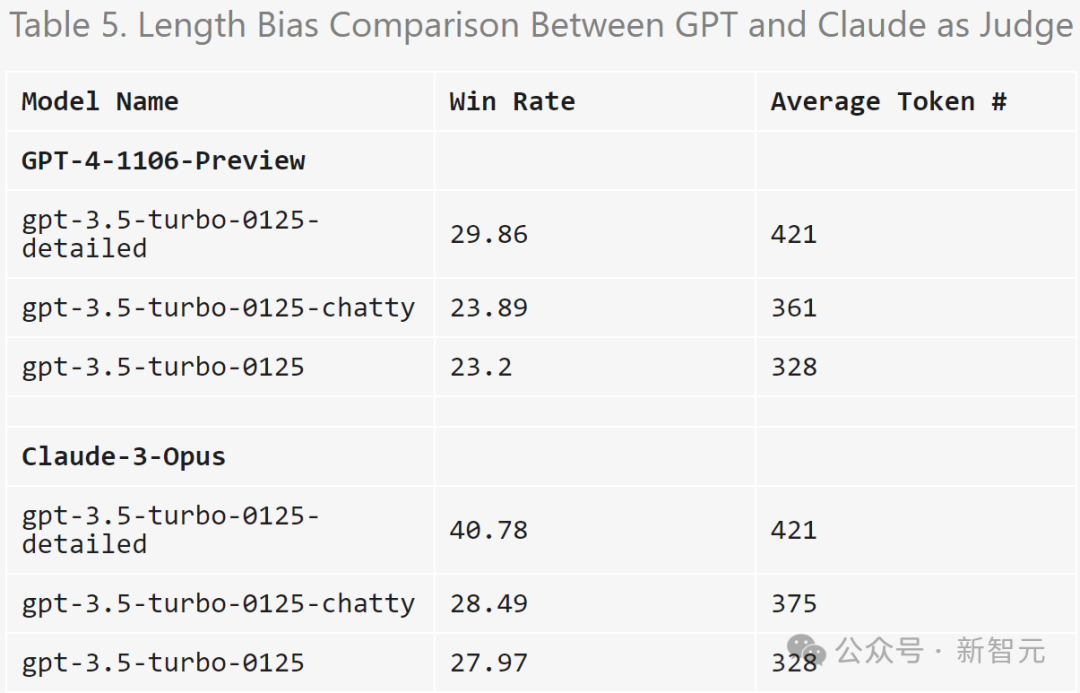

于是,询查东谈主员比较GPT-4-1106-Preview和Claude-3 Opus行为判卷老诚的阐发。

一句话归来:GPT-4是严父,Claude-3是慈母。

当使用GPT-4打分时,跨模子的可分离性更高(领域从23.0到78.0)。

而当使用Claude-3时,模子的得分大多都擢升了不少:自家的模子折服要良善,开源模子也很心爱(Mixtral、Yi、Starling),gpt-4-0125-preview也如实比我更好。

Claude-3甚而爱gpt-3.5-0613胜过gpt-4-0613。

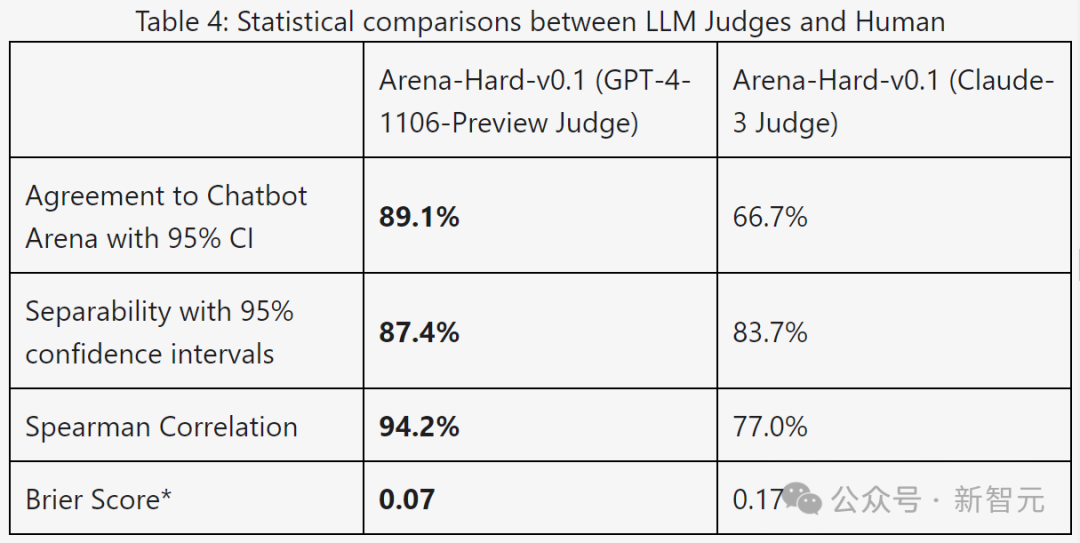

下表使用可分离性和一致性标的进一步比较了GPT-4和Claude-3:

从弃世数据来看,GPT-4在通盘标的上都显然更好。

通过手动比较了GPT-4和Claude-3之间的不同判断示例,不错发现,当两位LLM意见不一致时,庸俗不错分为两大类:

保守评分,以及对用户教唆的不同认识。

Claude-3-Opus在给分时比较优容,给出刻薄分数的可能性要小得多——它稀零彷徨是否要声称一个回报比另一个回报「好得多」。

比拟之下,GPT-4-Turbo会识别模子反馈中的装假,并以显然较低的分数处分模子。

另一方面,Claude-3-Opus未必会忽略较小的装假。即使Claude-3-Opus如实发现了这些装假,它也倾向于将它们视为小问题,并在评分经过中高出优容。

即使是在编码和数学问题中,小装假骨子上会皆备龙套最终谜底,但Claude-3-Opus仍然对这些装假赐与宽大处理,GPT-4-Turbo则否则。

关于另外一小部分教唆,Claude-3-Opus和GPT-4-Turbo以根柢不同的角度进行判断。

举例,给定一个编码问题,Claude-3-Opus倾向于不依赖外部库的简便结构,这么不错为用户提供最大西宾价值的反馈。

而GPT-4-Turbo可能会优先谈判提供最实用谜底的反馈,而无论它对用户的西宾价值怎样。

诚然这两种解释都是灵验的判断范例,但GPT-4-Turbo的不雅点可能与平日用户更接近。

研究不同判断的具体例子,参见下图,其中许多都阐发出这种气候。

局限性测试

LLM心爱更长的回报吗?

底下绘图了在MT-Bench和Arena-Hard-v0.1上,每个模子的平均token长度和分数。从视觉上看,分数和长度之间莫得很强的研究性。

为了进一步查抄潜在的冗长偏差,询查东谈主员使用GPT-3.5-Turbo对三种不同的系统教唆(原始、健谈、详备)进行了消融。

弃世标明,GPT-4-Turbo和Claude-3-Opus的判断都可能受到更长输出的影响,而Claude受到的影响更大(因为GPT-3.5-Turbo对GPT-4-0314的胜率越过40%)。

真谛的是,「健谈」对两位裁判的胜率影响不大,这标明输出长度不是惟一的身分,更详备的谜底也可能受到LLM评委的心疼。

履行使用的教唆:

detailed: You are a helpful assistant who thoroughly explains things with as much detail as possible.

chatty: You are a helpful assistant who is chatty.

GPT-4 判断的方差

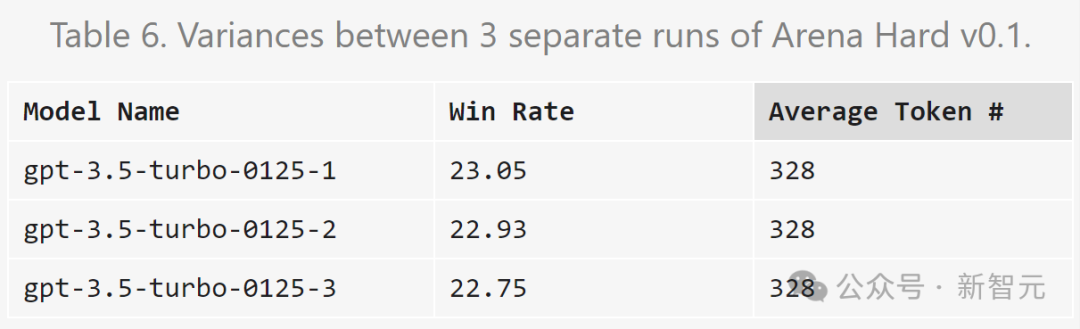

询查东谈主员发现,即使温度=0,GPT-4-Turbo仍可能产生略有不同的判断。

底下对gpt-3.5-turbo-0125的判断重迭三次并预料方差。

由于预算有限,这里只对通盘模子进行一次评估。不外作家淡薄使用置信区间来细则模子分离。