发布日期:2024-04-05 23:45 点击次数:85

“只需”10万好意思元,考核Llama-2级别的大模子。

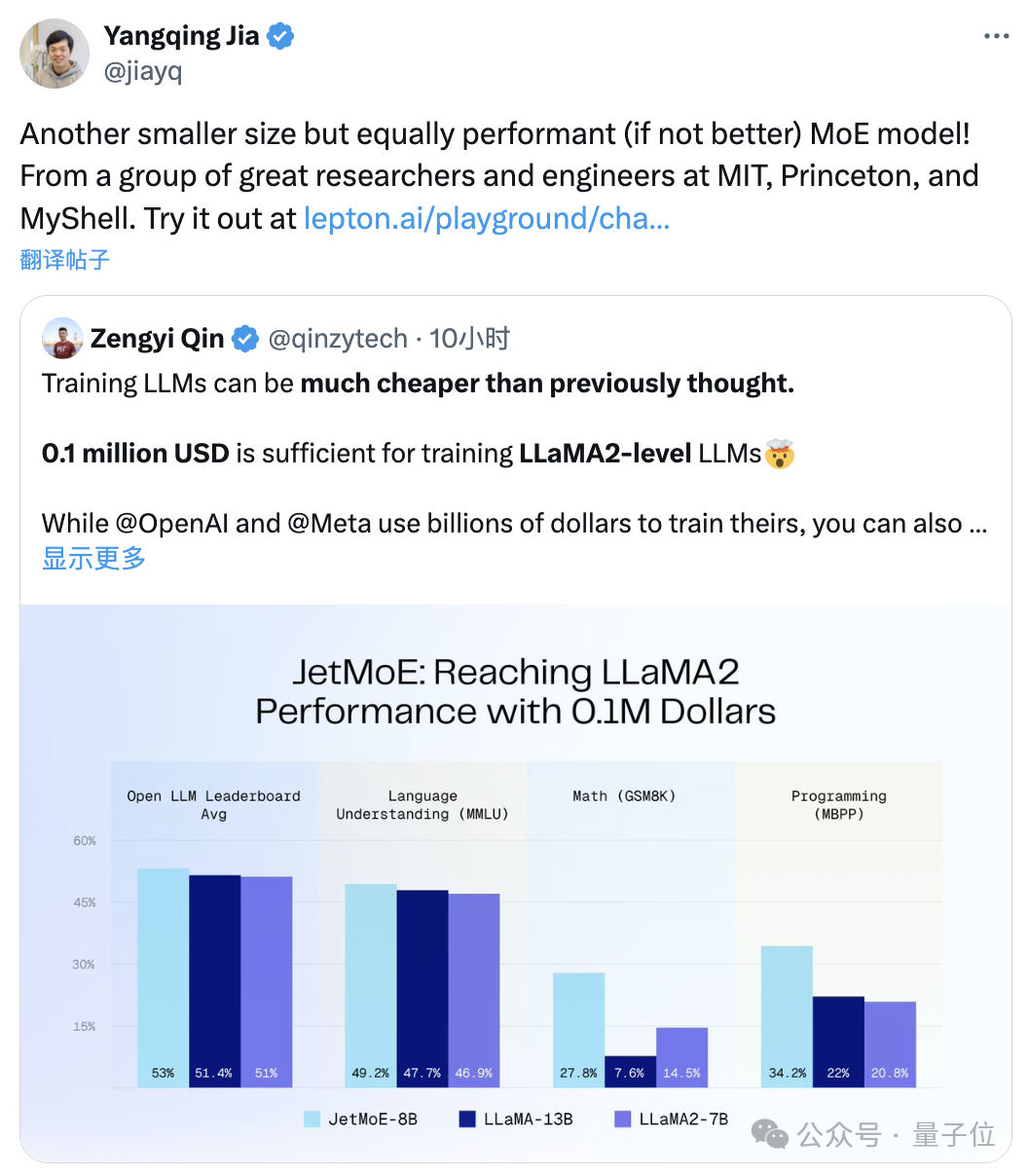

尺寸更小但性能不减的MoE模子来了:

它叫JetMoE,来自MIT、普林斯顿等参谋机构。

性能妥妥跳跃同等边界的Llama-2。

△

贾扬清转发

要知谈,后者但是数十亿好意思元级别的参预资本。

JetMoE发布即全齐开源,且学术界友好:仅使用公开数据集和开源代码,用虚耗级GPU就能进行微调。

不得说,大模子的打形资本,的确比东谈主们想的要低廉更多了。

Ps. Stable Diffusion前雇主Emad也点了赞:

10万好意思刀兑现Llama-2性能

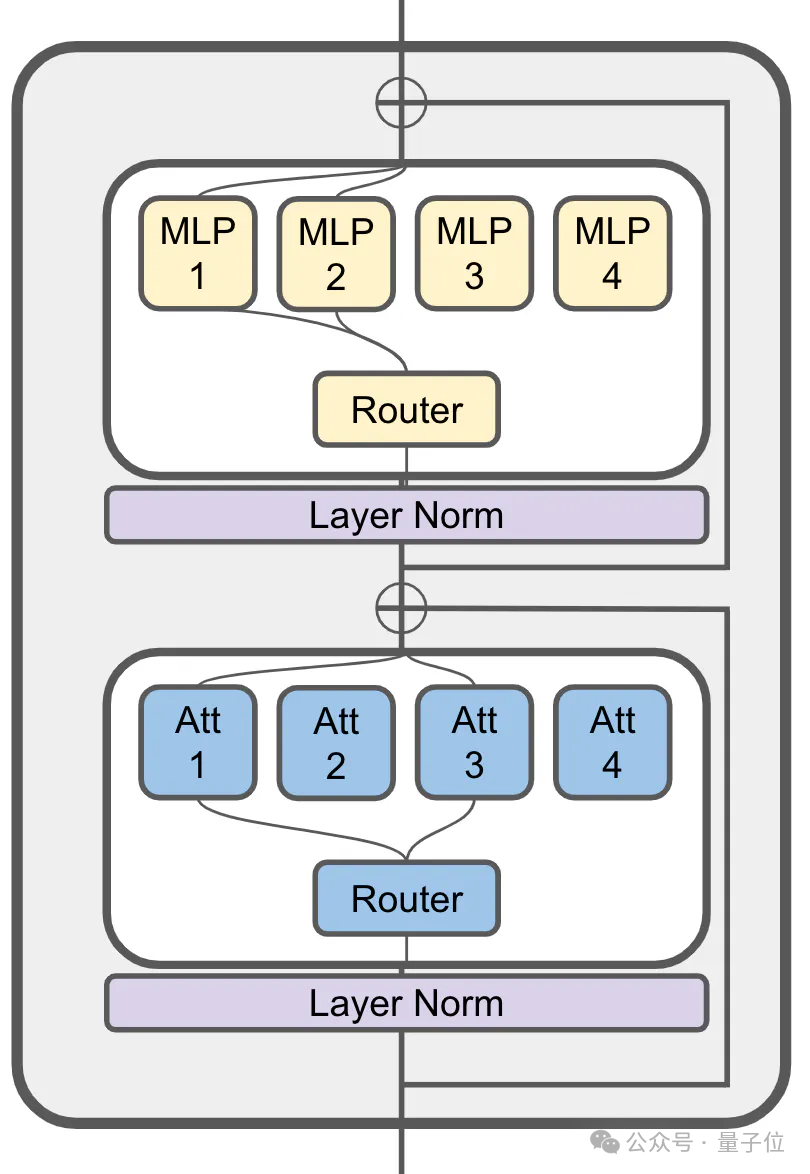

JetMoE启发于ModuleFormer的疏淡激活架构。

(ModuleFormer,一种基于疏淡民众夹杂(SMoE)的模块化架构,可提无际模子效果和无邪性,前年6月建议)

它的扎看法层中仍然使用了MoE:

80亿参数的JetMoE一共有24个区块,每块包含2个MoE层,分歧是扎看法头夹杂 (MoA) 和MLP民众夹杂 (MoE)。

每个MoA和MoE层又有8个民众,每次输入token激活2个。

JetMoE-8B使用公开数据探求的1.25T token进行考核,学习率5.0 x 10-4,全局batch size为4M token。

具体考核决策免除MiniCPM(来自面壁智能,2B模子就能赶超Mistral-7B)的想路,共包含两阶段:

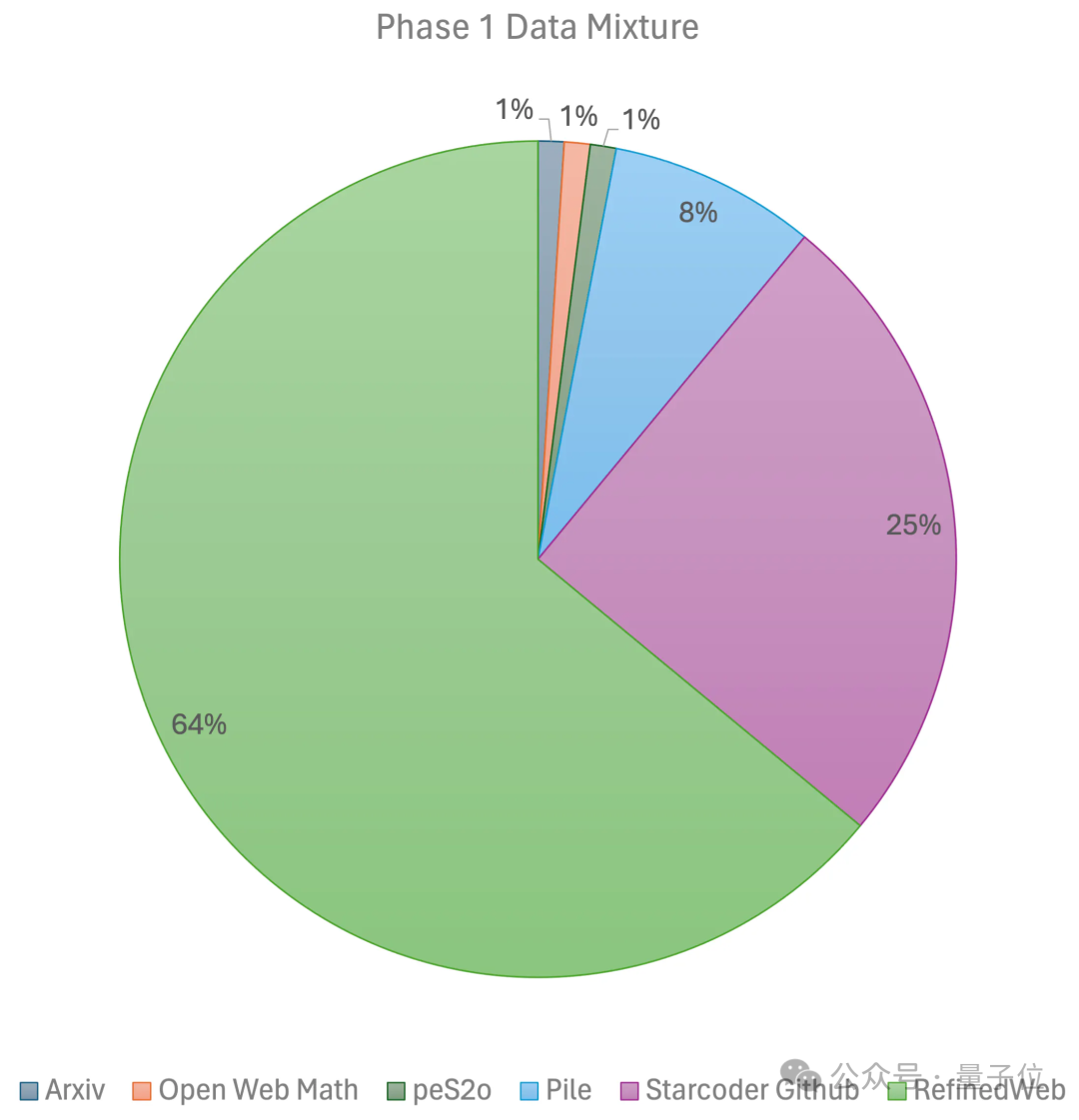

第一阶段使用线性预热的恒定学习率,用来容或边界开源预考核数据集的1万亿个token进行考核,这些数据集包括RefinedWeb、Pile、Github data等等。

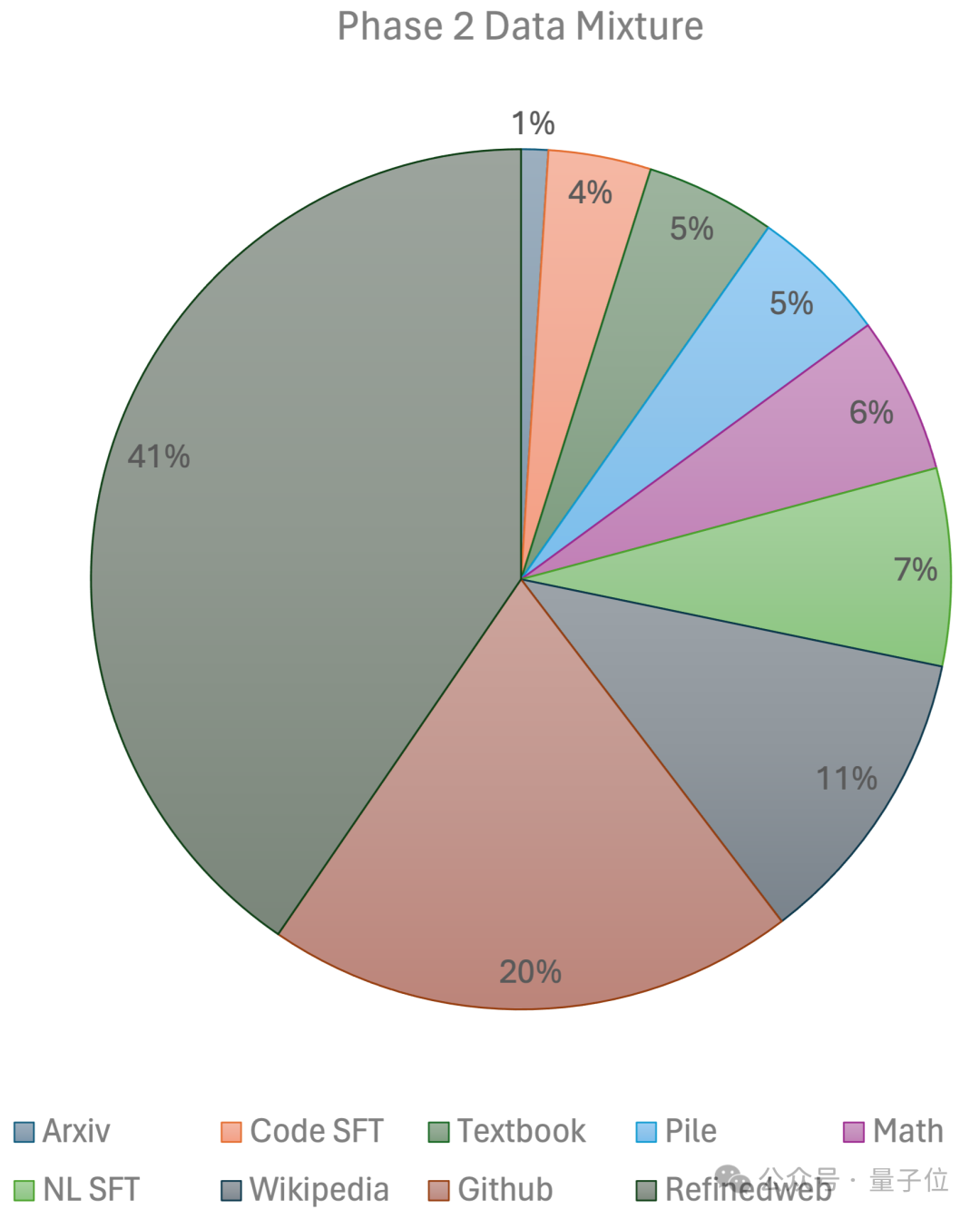

第二阶段则使用指数学习率衰减,外汇配资用2500亿个token考核来自第一阶段数据集和超高质地开源数据集的token。

最终,团队使用96×H100的GPU集群,破耗2周时辰、约8万好意思元处理JetMoE-8B。

更多工夫细节将在不久后发布的工夫报告上揭露。

而在推理历程中,由于JetMoE-8B仅具有22亿个激活参数,因此设想资本大大镌汰——

同期,它还收成了可以的性能进展。

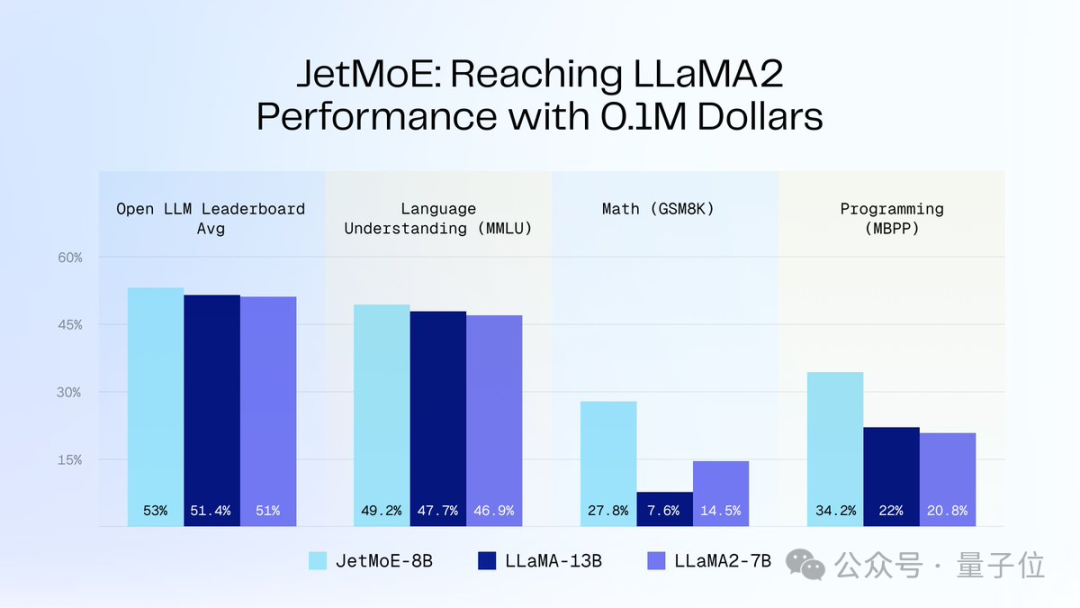

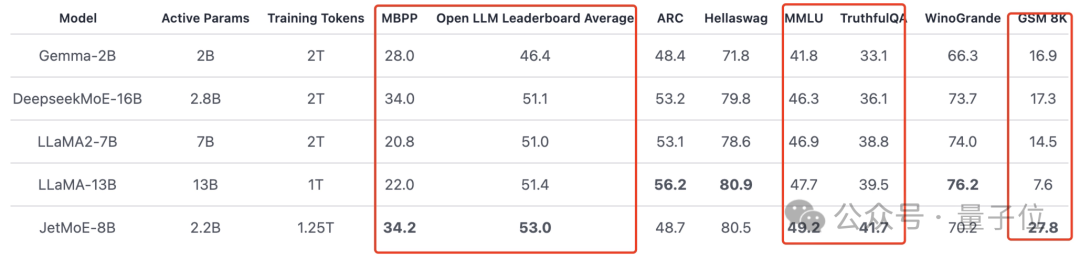

如下图所示:

JetMoE-8B在8个评测基准上获取了5个sota(包括大模子竞技场Open LLM Leaderboard),跳跃LLaMA-13B、LLaMA2-7B和DeepseekMoE-16B。

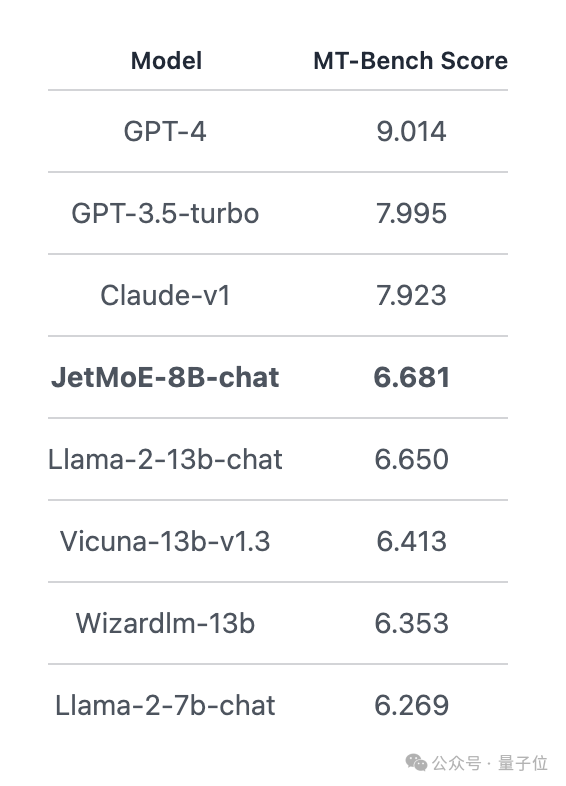

在MT-Bench基准上得分6.681,也跳跃了130亿参数的LLaMA2、Vicuna等模子。

作家先容

JetMoE一共4位作家,分歧是:

Yikang Shen

MIT-IBM Watson Lab参谋员,参谋标的NLP。

本硕毕业于北航,博士经验于Yoshua Bengio创办的Mila参谋机构。

国振 (Gavin Guo)

MIT博士在读, 参谋标的为3D成像的数据高效机器学习。

UC伯克利本科毕业,前年夏天算作学生参谋员加入MIT-IBM Watson Lab,导师为Yikang Shen等东谈主。

蔡天乐

普林斯顿博士在读生,本科毕业于北大应用数学和设想机科学,当今亦然Together.ai 的兼职参谋员,与Tri Dao伙同。

Zengyi Qin

MIT博士在读,同期在创业,MyShell的AI研发运用。

这家公司刚刚融资了1100万好意思元,投资者包括Transformer的作家。